Закрытие от индексации малоценных или маловостребованных страниц

Если мы говорим о качественной внутренней оптимизации — некачественных страниц в принципе не должно быть на сайте.

При проведении работ по оптимизации структуры URL мы рекомендуем:

- Выгрузить список всех таких URL, если они доступны по внутренним ссылкам.

- Выгрузить список всех таких URL из счетчиков сбора данных о посещаемости сайта, а также из панелей Яндекс Вебмастер и Google Search Console.

- Проверить новую версию структуры и убедиться, чтобы в рамках сайта теперь нет некачественных страниц и дублей.

- После обновления структуры URL для всех страниц, которые изменили код ответа сервера на 404, настроить 301-редирект на релевантные версии страниц, либо на категории каталога одним уровнем выше.

Предлагаем рассмотреть наиболее популярные примеры малоценных или маловостребованных страниц и рекомендации к их закрытию от индексации.

Примеры некачественных страниц и формат из закрытия

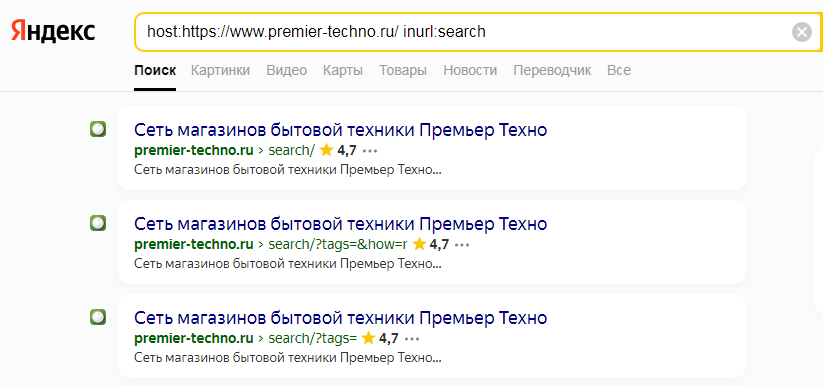

1. Страницы, которые генерируются внутренним функционалом поиска по сайту. Такой формат малополезных и маловостребованных у пользователей страниц встречается чаще всего при отсутствии контроля.

Решение:

Оптимально закрыть от индексации все URL-адреса, генерируемые внутренним поиском по сайту путем добавления в файл robots.txt директивы:

- Disallow: /search/*

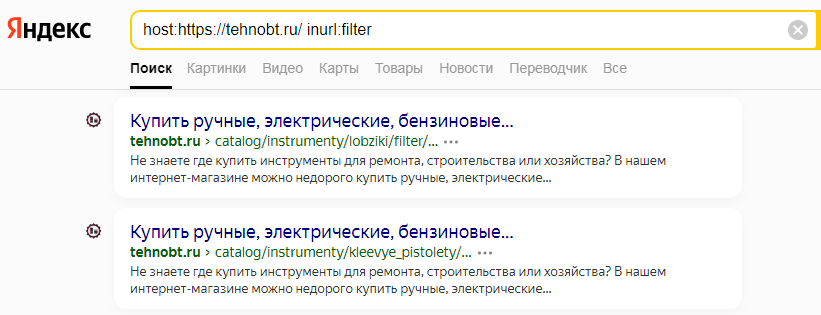

2. Страницы, которые генерируются функционалом фильтрации в разделах и подразделах каталога и не оптимизированы (не используются при продвижении сайта для привлечения НЧ и мНЧ трафика).

Решение:

Чтобы исключить проблемы с подобными страницами в выдаче поисковиков оптимально:

- Внедрить функционал, который позволит оптимизировать страницы фильтра и использовать их для привлечения низкочастотного трафика.

- При отсутствии пользовательского спроса рекомендуется исключить наличие внутренних ссылок на URL-адреса и закрыть их от индексации meta-тегом robots с параметрами: noindex, follow:

- meta name="robots" content="noindex, follow"

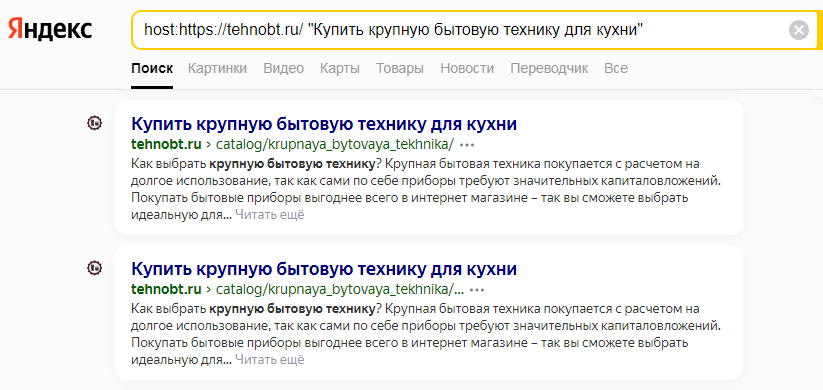

3. Дубли страниц (страницы с полностью идентичным контентом).

Решение:

- В первую очередь рекомендуется понять, в связи с чем на сайте появились такие страницы и принять меры по исключению их повторного появления.

- Исключить наличие внутренних ссылок на страницы-дубли.

- Настроить 301-редирект с дублей на основные версии страниц.

- Если по тем или иным причинам полностью устранить дубли страниц нет возможности, оптимально настроить тег , где для дублей страниц указать ссылку на каноническую версию страницы.

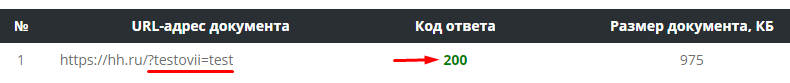

4. Страницы с неизвестными GET-параметрами.

Решение:

Для всех таких станиц рекомендуется настроить тег , где в качестве канонический страницы должны быть указан URL без GET-параметров.

Вывод

Как показывает практика, при должном подходе к внутренней оптимизации в рамках сайта не должно быть дублей страниц, в противном случае необходимо принять меры по их выявлению и устранению из индекса поисковиков.

Со своей стороны мы можем рекомендовать вам использовать сервис ведения проектов «Пиксель Тулс», который включает в себя комплекс инструментов для решения всех основных SEO-задач.

Дата ответа:

Автор ответа: Сергей Просветов

Дата ответа:

Дата ответа:

Дата ответа:

Дата ответа: