2. В Wordpress такая же ситуация с дублями как и в Joomla?

Борьба с дублями в Joomla

Николай, приветствую.

Можно с уверенностью сказать, что проблема дублей страниц для разных CMS актуальна по разному. Joomla здесь занимает лидирующее положение, её позиция на Олимпе виртуального анти-рейтинга — незыблема.

Мы не рекомендуем использовать Joomla для разработки сайтов любого типа, особенно для коммерческих и амбициозных информационных проектов.

Ситуация с WordPress — значительно лучше. Существуют довольно приличные по качеству плагины для этой системы управления, которые позволяют оперативно настроить и ЧПУ и автоматически проставить 301-редиректы со старых видов URL на новые.

Вероятно, для Joomla имеются аналоги, хотя наш опыт работы с сайтами, разработанными на этой системе управления, говорит о постоянно появляющихся технических проблемах и необходимости регулярного мониторинга наличия дубликатов страниц в индексе.

Решение проблемы дубликатов: новый сайт

Для полного решения проблемы попадания дублей документов в выдачу, особенно для нового сайта, оптимальной будет следующая последовательность действий (независимо от используемой CMS):

Настройка ЧПУ для всего сайта, так чтобы не было внутренних ссылок на страницы с GET-параметрами (на этапе разработки).

Запрет на индексацию всех страниц с GET-параметрами в файле robots.txt через директиву «Disallow: *?*».

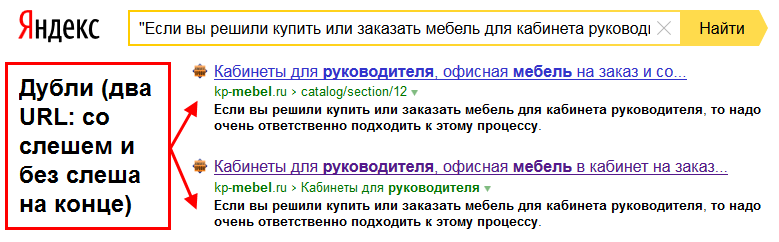

Постановка 301-редиректов на страницы со слешем (или без слеша) в конце, так чтобы все URL на сайте выглядели единообразно.

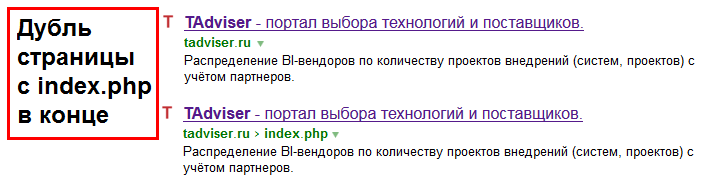

Постановка 301-редиректов с индексных страниц (index.php, index.html и т.д.) в корень.

Установка 301-редиректов со всех зеркал сайта на основное зеркало (в том числе и с версии с WWW или наоборот).

Указание директивы Host для Яндекса с заданием основного зеркала.

Корректная настройка атрибута rel="canonical" тега link.

Создание и обновление полной карты сайта со сверкой числа страниц в индексе поисковых систем с числом страниц определенных в карте сайта, для оперативного реагирования в случае появления проблемы.

Замечание 1: если у сайта проводятся рекламные кампании с настроенными UTM-метками и большим объемом трафика, то их закрытие от индексации можем приводить к неполному учёту поведенческих метрик для документов на сайте. Если объем трафика на страницы с UTM-метками составляет 5% и более, то пункт 2 из списка выше — рекомендуется опустить. Уделив особое внимание пункту 7 (настройке rel="canonical").

Решение проблемы для старых сайтов

Если на сайте уже наблюдается большое число дублей и требуется устранить их, то мы рекомендуем придерживаться следующей последовательности работ:

Сканирование всего сайта и страниц в индексе поисковых систем.

Выявление всех дублей, составление таблицы дубликатов.

Массовая постановка 301-редиректов с логических дублей на канонические документы.

Устранение причин появления дублей, а именно:

- Изменение/Удаление всех внутренних и внешних ссылок на данные страницы. Если все внешние ссылки не получается устранить, то требуется поставить 301-редирект с данных станиц на корректные URL.

- Настройка атрибута rel="canonical" тега link.

Постановка 301-редиректов на страницы со слешем (или без слеша) в конце, так чтобы все URL на сайте выглядели единообразно.

Постановка 301-редиректов с индексных страниц (index.php, index.html и т.д.) в корень.

Установка 301-редиректов со всех зеркал сайта на основное зеркало (в том числе и с версии с WWW или наоборот).

Указание директивы Host для Яндекса с заданием основного зеркала.

Ожидание учёта данных изменений поисковыми системами.

Контроль числа страниц в индексе поисковых систем.

Замечание 2: настройка rel="canonical" в большом числе случаев оказывается достаточно ресурсоёмкой для программистов и не всегда оказывается экономически оправданной для небольших проектов. В данных случаях, вместо rel="canonical" используют:

- Добавление (по регулярному выражению) закрывающего от индексации meta-тега robots на «мусорные» страницы.

- Скрытие страниц в файле robots.txt (хуже, так как директивы в файле периодически игнорируются поисковыми системами Яндекс и Google).

Не стоит забывать, что скрытие от индексации страниц через meta-тег или файл robots.txt рекомендуется использовать лишь в том случае, когда на данные страницы отсутствуют внутренние и внешние ссылки.

Удачи в самостоятельной настройке сайта под SEO и устранении всех дублей в индексе поисковых систем!

Дата ответа:

Автор ответа: Дмитрий Севальнев

Дата ответа:

Дата ответа:

Дата ответа:

Дата ответа: